¿Alguna vez te has preguntado si decirle «por favor» y «gracias» a ChatGPT realmente marca la diferencia? La ciencia dice que sí.

El poder de las palabras en la era digital

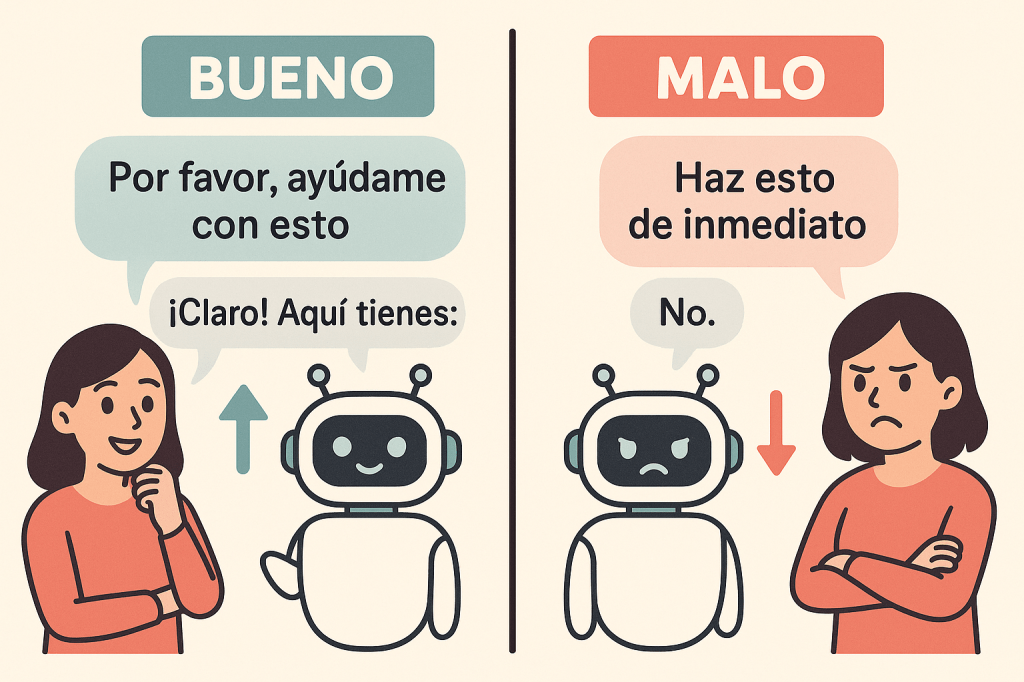

En un mundo donde las interacciones con asistentes de IA se vuelven cada vez más comunes, emerge una verdad fascinante: la forma en que nos comunicamos con estos sistemas influye significativamente en la calidad de las respuestas que obtenemos. No es solo una cuestión de etiqueta digital, sino de resultados tangibles.

Las investigaciones recientes revelan un panorama sorprendente sobre cómo nuestro lenguaje moldea el desempeño de los sistemas de inteligencia artificial, especialmente en el procesamiento del lenguaje natural. Lo que comenzó como una curiosidad anecdótica se ha convertido en un campo de estudio con implicaciones profundas para educadores, profesionales y usuarios cotidianos.

La cordialidad no es solo cortesía, es estrategia

Según estudios compartidos en plataformas académicas, los modelos de IA entrenados con textos humanos responden notablemente mejor a interacciones amables. No es casualidad: estos sistemas están diseñados para imitar patrones lingüísticos humanos, y la cordialidad en los prompts alinea las respuestas con tonos más empáticos y cooperativos.

Investigadores de Cambridge y la Universidad de Bedfordshire encontraron que los profesores que utilizaban un lenguaje positivo al interactuar con herramientas de IA obtenían materiales didácticos de mejor calidad. Este hallazgo sugiere que la amabilidad no solo mejora nuestras relaciones humanas, sino también nuestra relación con la tecnología.

«La cordialidad no solo mejora la calidad de las respuestas, sino que también fomenta una interacción más fluida y ética con la IA, especialmente en contextos educativos y de atención al cliente.»

Cuando las palabras duelen: el efecto de los malos tratos

En el lado opuesto del espectro, el uso de lenguaje agresivo u ofensivo deteriora significativamente la calidad de las interacciones con IA. Un estudio publicado en Business Insider señala que los modelos tienen dificultades para identificar y corregir lenguaje tóxico cuando se les expone a prompts agresivos.

Más preocupante aún, la exposición repetida a lenguaje ofensivo puede reforzar sesgos en los modelos, perpetuando respuestas discriminatorias. Según un informe de Amnistía Internacional, los sistemas de IA pueden reproducir sesgos históricos si se entrenan con datos que contienen lenguaje discriminatorio.

Esta realidad plantea una pregunta inquietante: ¿estamos, sin saberlo, enseñando malos hábitos a nuestros asistentes digitales?

El arte de los prompts específicos

Si has utilizado ChatGPT o cualquier otro modelo de lenguaje, probablemente hayas notado que la calidad de tu prompt determina en gran medida la calidad de la respuesta. Esta observación tiene ahora respaldo científico.

La ingeniería de prompts se ha consolidado como un factor crítico para optimizar el rendimiento de los modelos de IA. Estudios de Lionbridge demuestran que los prompts claros y detallados mejoran significativamente la calidad de las traducciones y la generación de contenido multilingüe.

En contextos educativos, la Universidad Carlos III de Madrid encontró que los estudiantes que usaban prompts específicos en tareas de escritura experimentaban menos ansiedad y obtenían resultados más alineados con los objetivos académicos.

La paradoja de los entornos tóxicos

Uno de los debates más intrigantes en el campo de la IA se centra en si los modelos deberían exponerse a entornos tóxicos durante su entrenamiento para mejorar su robustez y capacidad de moderación.

Por un lado, estudios publicados en la Revista Latina de Comunicación Social sugieren que la exposición controlada a datos tóxicos puede fortalecer la capacidad de los modelos para detectar y mitigar la toxicidad en plataformas como redes sociales.

Por otro lado, un informe de Amnistía Internacional advierte que esta exposición puede perpetuar sesgos discriminatorios si no se gestiona adecuadamente. Este dilema subraya la tensión constante entre mejorar el rendimiento técnico y garantizar el desarrollo ético de la IA.

El camino hacia una IA más humana (y humanista)

Las consideraciones éticas en la interacción con IA van más allá del lenguaje. La privacidad de datos, los sesgos inherentes, la formación adecuada de usuarios y el impacto ambiental son desafíos que requieren atención urgente.

Un dato sorprendente: según un informe de OficinaC, entrenar un modelo grande de IA puede emitir hasta 284 toneladas de CO2, equivalente a las emisiones anuales de 57 personas. Esta huella ecológica nos recuerda que nuestras palabras digitales tienen consecuencias en el mundo físico.

Reflexiones finales

La forma en que nos comunicamos con la IA no es trivial; es un factor determinante en la calidad de las respuestas que recibimos y, a largo plazo, en el tipo de sistemas que estamos ayudando a desarrollar.

Como usuarios de estas tecnologías, tenemos la responsabilidad de:

- Cultivar interacciones cordiales y respetuosas

- Aprender a crear prompts específicos y efectivos

- Mantenernos informados sobre las implicaciones éticas de nuestras interacciones digitales

- Abogar por el desarrollo responsable de la IA

En un futuro donde las fronteras entre lo humano y lo artificial se difuminan cada vez más, nuestras palabras son el puente que conecta ambos mundos. Construyámoslo con consciencia.

¿Qué experiencias has tenido al interactuar con sistemas de IA? ¿Has notado diferencias en las respuestas dependiendo de tu forma de comunicarte? Comparte tus reflexiones en los comentarios.

Deja un comentario